Versatile Diffusion:革新的なマルチモーダル拡散モデルの全貌

Versatile Diffusion(VD)とは

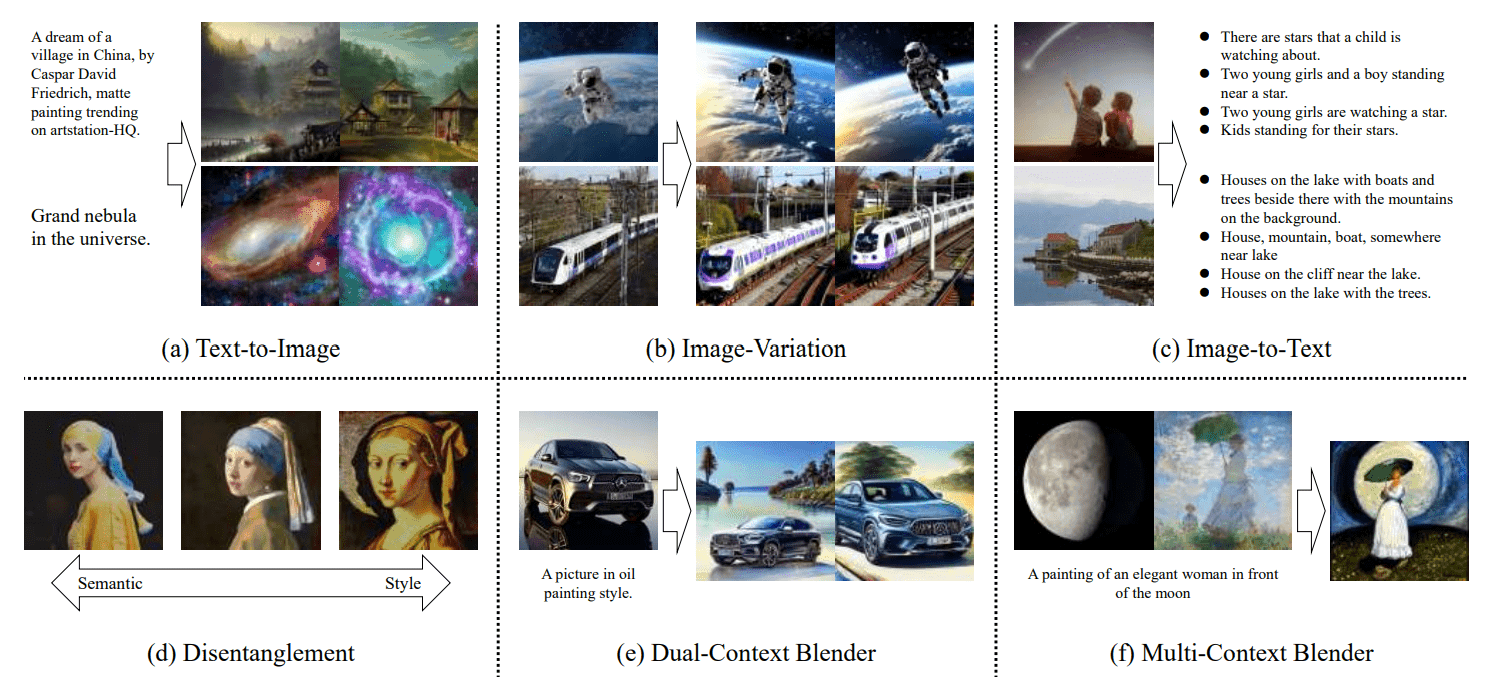

最先端のAI技術の進展において、Versatile Diffusion(VD)は注目を集めています。この革新的なマルチモーダル拡散モデルは、テキストと画像を統合的に扱うことが可能で、Text-to-Image、Image-to-Text、Image-to-Image、Text-to-Textといった多様なタスクを実現します。特に、プロンプト入力による画像編集の柔軟性は、クリエイティブな分野での応用が期待されています。

モデルアーキテクチャの特徴

VDのモデルアーキテクチャは、「Global Layer」「Data Layer」「Context Layer」の3つの層から構成されています。これにより、異なるフロー間でのパラメータ共有や時間情報の統合が可能となり、より高度なデータ生成を実現します。例えば、Text-to-Imageタスクでは、画像用のData Layerとテキスト用のContext Layerを通じて、次のステップの結果が生成されます。この柔軟な構造は、VDの多様な応用可能性の基礎を形成しています。

CLIPの活用とその影響

VDでは、CLIP(Contrastive Language–Image Pretraining)を用いてテキストと画像のコンテキスト情報を取得します。CLIPは、テキストと画像のペアを学習し、両者の関連性を理解することができるモデルです。この技術の活用により、VDはテキストに基づいた画像生成や、画像に基づいたテキスト生成をより精度高く行うことが可能になります。

VDの応用範囲

VDの応用範囲は広く、クリエイティブな画像生成から、テキストベースの画像編集、さらには教育や研究分野でのデータ可視化まで、多岐にわたります。特に、プロンプトによる直感的な操作性は、ユーザーが容易に複雑なタスクを実行できるように設計されています。

評価と将来性

VDの評価実験では、その生成能力の高さが明らかにされています。特に、Text-to-ImageやImage-Variationタスクにおいて、他のベースラインモデルを上回る性能を示しています。また、将来的には、3D生成や音声、音楽など、さらに多くのモダリティをカバーする可能性が論じられており、VDの進化はまだまだ続くと予想されます。

まとめ

Versatile Diffusionは、テキストと画像を統合的に扱うことができる革新的なマルチモーダル拡散モデルです。その柔軟なアーキテクチャとCLIPの活用により、多様なタスクを高い精度で実現します。クリエイティブな分野から教育、研究まで、その応用範囲は広大です。今後の進化にも大いに期待が寄せられています。

コメント